CopyRight©2020-2030 www.poppur.com

我想,没有几个人没看过英特尔那个“噔噔噔噔...”(广告结尾音)的Intel Inside电视广告吧?在PC时代,你家的电脑如果用的是英特尔处理器,就代表你的电脑是高档的,性能强劲的,这已经成为一种共识,也是一个值得载入史册的经典营销案例。然而,在智能手机时代,Intel这个巨无霸却错过了整个生命周期,只能眼睁睁看着对手高通在这个领域大赚特赚。眼看自己在PC时代积累的优势快要消失怡尽,可想而知Intel内心有多崩溃。随着第三次计算平台浪潮即将出现(VR/AR时代),Intel终于找准了节奏,在最新举行的IDF 2016(英特尔开发者年会)上,他们拿出了旗下第一款VR/AR眼镜设备 - Project Alloy(中文念阿莱)。

在Intel Project Alloy发布之前,市场上已经有不少成熟的VR眼镜产品,像是Oculus的Rift,HTC的Vive。然而他们都不能与Project Alloy相提并论,因为Project Alloy是首款单机(单体VR一体化眼镜)集成了处理器、空间定位和行为捕获的虚拟现实设备(Intel把它叫做混合现实眼镜)。而前面两个对手则是依靠外部计算(Oculus Rift和HTC Vive都必须外接高性能计算机)并且需要外置的空间与行为测算器,例如是HTC Vive得靠激光灯塔才能完成人物在室内的行为监测与录入。而另一方面,像Gear VR这种插手机来用的单体VR眼镜,凭借自身根本无法获得空间定位及行为捕抓,因此注定是被淘汰的一族(由Google Project Tango来接替)。也就是说,Intel Project Alloy是目前功能最完善的一体式VR/AR眼镜设备,也是VR/AR眼镜的终极模式,Intel给它取了个名字-混合现实(Merged Reality)眼镜。说到这里,估计得给大家简单普及一下什么是“VR,虚拟现实”,什么是“AR,增强现实”,什么是“MR,混合现实”。

VR虚拟现实,生成一个完全虚拟的世界,虚拟的游戏角色在这个世界里活动【全部是虚拟的】

AR增强现实,生成一个虚拟人物,在真实(摄像头拍摄的现实场景)世界里活动【虚拟的放到真的里】

MR混合现实,把你转化成虚拟人物(现实中你的一举一动将与虚拟世界里的你联动),在虚拟世界里活动【真的放到虚拟的里】

以上就是对于VR、AR和MR最精准也是最简单的解释,其实一点也不深奥,以后有人问起你就会答了。Intel Project Alloy是一款MR混合现实眼镜,那也就是说,通过这个眼镜,它可以把你现实中的一举一动投射到虚拟世界里的你,然后在虚拟世界里同步活动。那么这款眼镜就必须具备行为捕获和空间定位能力,而这也是Project Alloy最高技术含量的部分。

Project Alloy眼镜怎么捕获你的行动

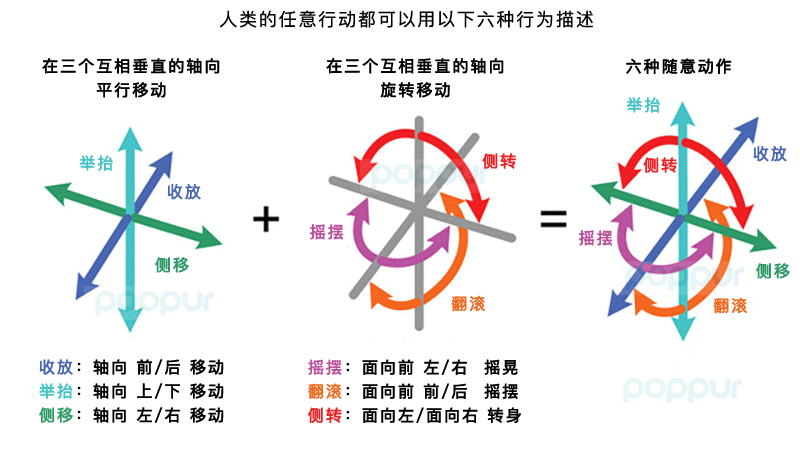

要让一个设备“感知”你的所有行动,它必须具有六种随意行为捕获能力,看下图:

上图就是告诉你,一个人或物体的所有行为,都可以由以上6种动作囊括,分别是最简单的三种平行位移:

收放 - 向前走向后退,游戏里的向前走和脸朝前的向后退避让

举抬 - 举起放下杠铃,游戏里的抬起放下物品

侧移 - 脸朝前的左右移动,游戏里篮球防守的左右碎步移位

以及更高级的三种旋转动作:

摇摆 - 面朝前左右摇晃上肢,体操里的左右拉伸躯干动作

翻滚 - 朝前鞠躬或向后俯身,游戏里的前滚翻后滚翻等

侧转 - 军训里的向左转向右转,由脸和躯干朝前改变为脸和躯干整体转向左或右

只要一个传感系统具备捕抓以上6种行为的能力,我们就称之为6度自由传感系统,也被我们称之为完美的动作捕获系统。

这个6度自由传感系统就是区别一个VR/AR眼镜性能高低最关键的因素,因为它涵盖了动作捕获,深度检测,信号处理,信号合成的工作。对于一款VR眼镜来说,如果人物动作的改变到最终显示的改变延迟超过20ms将造成使用者晕动症的产生(就是晕车的感觉,严重还会休克)。这就是说Project Alloy从动作捕获,周边场景深度采集与建模计算,再综合到一起生成混合现实的数据,并输送到眼镜的液晶显示屏显示完成,全部步骤加在一起的执行时间要小于20ms。并且由于目前大多数液晶显示屏物理刷新一次显示就要4-7ms的时间(这已经是中高档的液晶显示屏了),所以留给前面采集和处理步骤的时间最多只有13-16ms的时间,这样说能让你明白个中难度有多大了吧?

于是乎,卖8-900元的三星Gear VR根本没想过要支持动作捕获(就更别提国内那堆吹得上天入地的“豪华版Google Cardboard眼镜”了),而能做动作和空间检测的Oculus Rift和HTC Vive不单价格不便宜,而且检测方式也不够完美,因为它们都是通过外置的红外灯塔激光测距系统,先一步测算好固定空间的尺寸(就是人们使用前必须先在固定房间里设置好灯塔,在使用过程中你不能超过这个规定好的范围)。而Intel则是通过在Project Alloy前端加入自家RealSense 300空间定位仪完成这个功能的,而且,它不需要预先设置好活动空间,你可以走到哪,它实时计算到哪,牛吧?

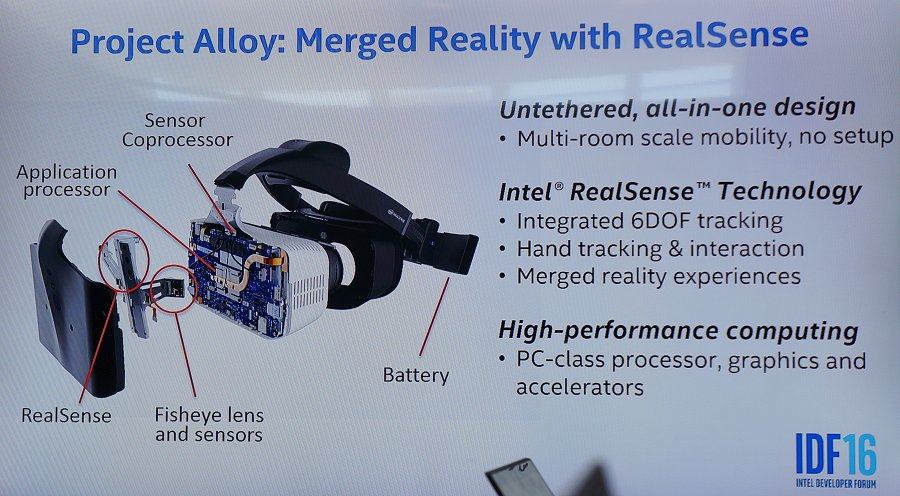

通过上图我们看到,Intel Project Alloy混合现实眼镜构成并不复杂,内部结构跟传统一体式VR眼镜就多了一个RealSense监控器而已,但其实技术含量最高也就是这个RealSense深度传感器。

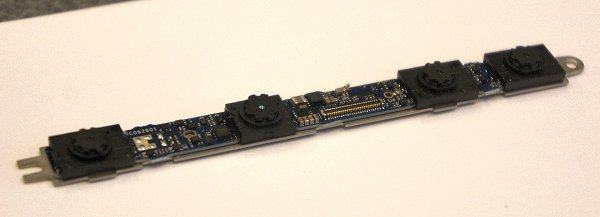

Intel RealSense深度传感器

如果你说Intel在智能手机发展的这些年都偷懒去了,当然是冤枉它了。RealSense深度传感器就是他们在这段时期内一个重要的研究成果,别小看这种类似于摄像头之类的设备,如果家里有玩游戏机的应该会联想起微软的Kinect或者PS Move体感棒,没错,其实他们本质上都是一样的东西,只是实现的方式和采样的精度之间天差地别。

这是加在本次IDF2016 Project Alloy展示样机上的RealSense 300深度传感器,在明年Project Alloy正式出样的时候,与之搭配的则是性能更强的Z400型号。

升级后的RealSense 400深度传感器将更轻,更薄,并且可以检测到距离更远的空间数据。同时依赖于Intel强大的芯片研发与生产工艺,RealSense 400上的数据处理芯片能够处理比现在最快的深度传感器多一倍的数据(目前最快的深度传感器检测数据为每秒1800万个测量点),看上面这幅有点像红外线热力图的样张,其实这是一幅深度感知图片,所谓的3D场景测算传感器其实就是一个深度感知能力的3D摄像头组合,通过往外发射红外光然后通过另外一个镜头接收从而测算反射的时间,最终估算前端物体距离的远近。各种深度传感器唯一区别就是采样的密度和测量的最远与最近距离以及处理速度,而这张红外热力图样的照片向我们展示了RS400恐怖的采样能力(3D场景测算精度,也代表空间重绘的精度)。我们可以假设这样一个场景,在一个房间里有一张椅子,对于测算精度不够的深度传感器来说,椅子部分它们可能直接用一个立体方块来代替,而RealSense400或许能直接描绘出椅面和四条凳脚以及中间空出来的空间。

Project Alloy通过在眼镜上集成了6度自由传感器及RealSense深度感知仪,华丽转身成为了一个混合现实眼镜。你们一定会好奇混合现实眼镜和我们现在经常听到的VR眼镜,譬如是入门级的Gear VR又或是顶级的HTC Vive有什么区别?看下图

在Intel Project Alloy中,只需通过该单一眼镜,即可实现对你手部动作(细致到每一只手指行为)的捕获并投射到虚拟现实世界中(留意上面动画中手指的动作)。作为对比,Gear VR不具备任何动作捕抓能力,而HTC Vive和Oculus Rift仅通过遥控杆不具备如此细腻的动作感知能力。当然,在现场演示中,我们目测到一些动作延时,以及投射定位精度并不是太高的问题,但以目前的科技水平,这个演示效果已经足够震撼。后续通过用更强的传感器和处理器应该能改进。

对于像HTC Vive和Gear VR这样的VR眼镜来说,上图中的效果是天荒夜谈级别的。在上面的演示中,主人公在虚拟现实世界里铸造一个金属器皿,此时他掏出一张真的纸币,用这个纸币在虚拟世界里切削这个金属器皿,难就难在钱币的边角部位很薄,而这样的物体行为也能很好的被Project Alloy捕抓到并且较精确的与虚拟世界里的金属器皿联动(留意金属器皿切割度的深浅),这里所包含的技术含量与难度是无法通过这样一个动画就能表达的(只能说姜还是老的辣啊,Intel牛逼)。

Project Alloy的未来

当你看到这一章节,你可能以为Intel会像微软HoloLens或HTC Vive之类,将亲自上阵并销售Project Alloy产品。而事实上Intel的做法更为聪明,他还是走回Wintel(Windows+Intel)联盟 + 一堆OEM小弟的PC成功路线。一方面,通过与微软的合作,在明年所有的Windows10电脑都将加入系统级的虚拟现实功能支持(我们相信可能会用类似DirectX这样的底层API模式加速虚拟现实各个环节的输入输出速度),同时以Project Alloy为技术平台,授权给其它厂商生产并制作OEM的Alloy眼镜,这就像之前电脑DIY的主板,Intel提供芯片组,设计规范和指南,然后一堆小弟华硕,微星,技嘉等等厂商围绕这个标准打造各自品牌的主板,Intel赚的是卖CPU和芯片组的钱。这一模式在过去的20年被证实为非常成功的,它能迅速,有效的降低新产品的价格门槛。而价格,正是目前制约虚拟现实设备普及的最大因素。

正面那几个透镜就是RealSense深度传感器的红外发射与接收透镜,中间白色带散热孔的是机身本体,里面有Intel赖以赚钱的CPU模块(展示机用的是Skylake处理器)

由于Project Alloy属于一体式VR眼镜,机身还带了电池模块,因此眼镜本体有点重,Intel为此设计了额式承重布局,压力主要积聚在前额部分,据佩戴过的人反馈说,虽然感觉有点重,但总体还算舒适。

由于目前Project Alloy仅属于技术预览阶段,机身上供调试的接口比较多,同时Intel也没有公布该眼镜具体的FOV可视角参数与电池可用时间等细节。延迟听说是已经改善到35-38ms了,虽然离完全不吐的20ms延迟还有一定距离,但随着明年更强大性能的Kaby Lake处理器及更佳感知能力的RealSense 400深度传感器的加入,这一数字能进一步获得改善,最后再通过换用更快的显示屏以及windows底层的优化,相信接近或达到20ms应该是非常有可能的。而且你要明白的是,这是一款无线VR眼镜,它不用像HTC Vive那样拖着一大坨的线进行游玩,这样游戏性和临场感是靠线还有高性能主机所不能比的(这是一步反超并绝杀的节奏),估计看完本次IDF发布会,HTC和Oculus头都大了。与此同时,头大的还有Google,他们的Daydream就喊了个口号,一直没下文了,在VR领域以Cardboard做出点名堂的Google会被Intel弯道超车吗?还真难说哦

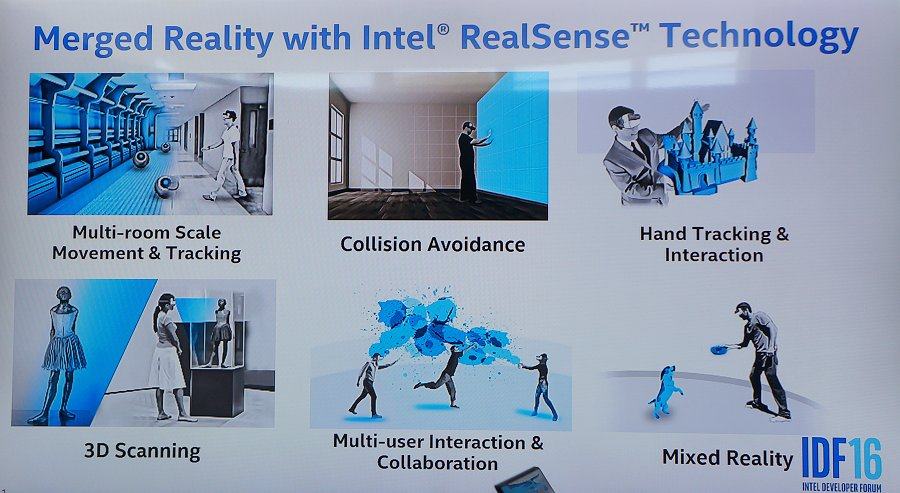

Intel觉得混合现实能被应用到如上场景,而事实上,这些图片和说辞,远不如下面这个视频来得震撼。是的,人类从没有像现在这般屹立在文明彻底革新的时代边缘,再往前一步,你对过往一切一切的认知和你的未来,都将发生惊天动地的巨变。这也是POPPUR致力于告诉大家的美好未来 - 随处皆体验,脑想即真实。

Intel设想我们的未来(当你拥有Project Alloy混合现实眼镜后的人生)

上一篇:移动手机VR平台哪个好?Daydream VR还是Gear VR?

下一篇:Oculus公司正在进行VR产品改进,或将推Oculus Rift CV2